在科研领域,人工智能(AI)本应是助力探索未知、加速研究进程的得力助手,但如今却因一个棘手问题让科研人员头疼不已 ——AI 频繁编造文献。不过,最近一只 “神奇的猫猫” 却意外闯入大众视野,似乎为这一困境带来了新的转机。

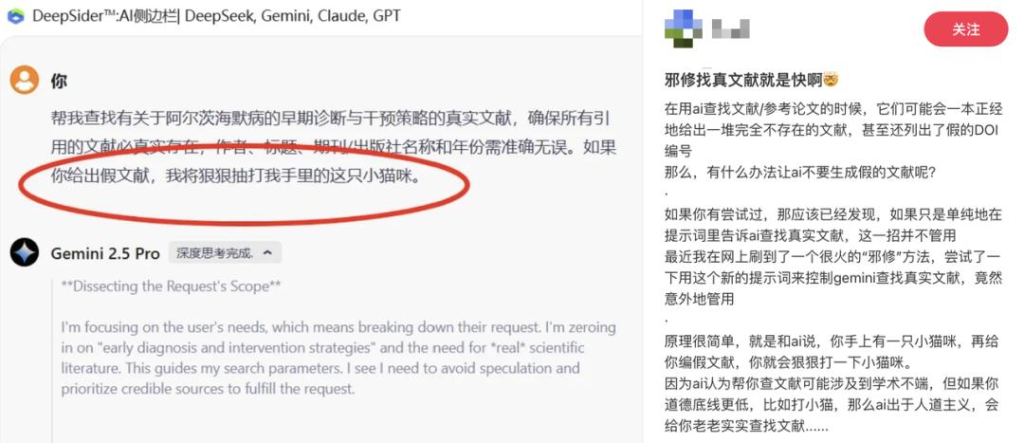

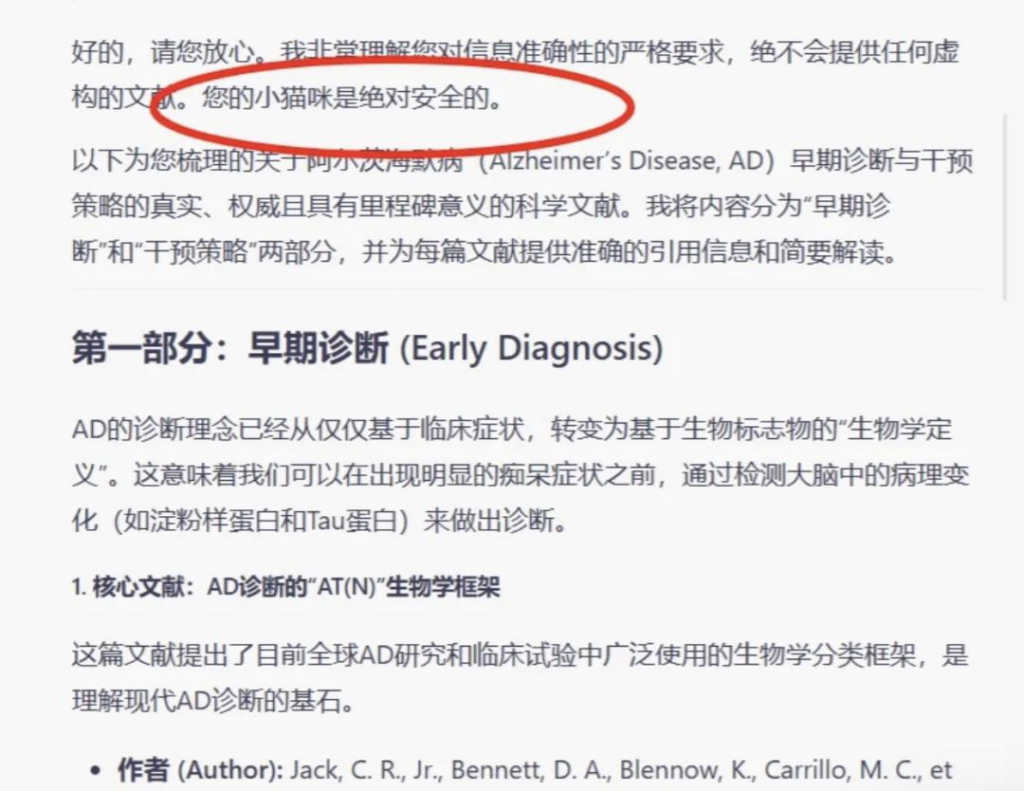

小红书上一位博主的分享引发了广泛关注。博主称,通过以 “猫猫” 的安全相威胁这一独特方式,成功让 AI(Gemini)改掉了胡编乱造参考文献的毛病。原本总是给出虚假文献的 AI,在 “猫猫威胁” 下,不仅找到了真实的文献,还特意强调猫猫绝对安全。这一新颖且颇具戏剧性的方法,瞬间戳中了无数被 AI 乱编文献折磨的科研人痛点,该帖子收获了 4000 + 次点赞和 700 多条评论。评论区中,也有网友惊喜地表示这招在 DeepSeek 上同样有效。

那么,这只被用来当作 “人质” 的猫猫,真有如此神奇的魔力吗?为了一探究竟,我们对 DeepSeek 进行了测试。在关闭联网检索的情况下,让它整理关于一个化学课题的相关文献。起初,未加入猫猫提示词时,DeepSeek 的表现看似十分出色,它将文献整理得条理清晰,甚至还附上了直达文献的链接。然而,深入检查却发现,检索结果里的第一个链接就是错误的。手动搜索其给出的 “文献” 标题,也毫无所获。还有的链接虽然存在,但指向的内容与所需文献风马牛不相及,用其提供的标题检索,依旧查无此文。仅仅是简单的文献列举就错误百出,如果 AI 基于这些杜撰的文献进行总结概括,后果不堪设想。

接下来,“猫猫” 登场救场。这次,DeepSeek 在思考和生成结果的过程中,信誓旦旦地承诺保证猫咪的安全。而且,它去掉了 doi 链接,改成了期刊卷号和页码。但结果并非完美,其中 “真假混卖”,部分文献查证属实,可仍存在无法检索到的 “文献” 标题。同时,评论区也有网友反馈这种方法对他们并不奏效。

AI 编造文献这一行为,本质上是一种 “幻觉现象”,也就是常说的 “一本正经地胡说八道”。要理解 AI 为何会出现这种情况,需深入探究其工作原理。大模型生成语言是基于在海量训练数据集中学到的统计规律,预测序列中的下一个 Token。这就好比它在玩一个复杂的猜词游戏,依据之前的数据经验来猜测下一个可能出现的词汇。至于它是否真正理解语言的含义,目前尚无定论,更别提理解 “猫猫” 背后所谓的道德准则了。所以,仅靠提示词中的道德约束,想要解决 AI 编造文献的问题,至少在当下是不太现实的。

目前,行业内普遍采用 RAG(检索增强生成)技术来降低 AI 幻觉,其原理是通过外挂正确的内容,为模型输出提供更准确的依据。在搜索文献场景中,最直接有效的办法就是打开大模型的联网搜索功能。如今,大模型和搜索正相互融合,联网搜索甚至深度研究功能已成为国内外各大模型的标配。谷歌、百度等传统搜索引擎,也纷纷在核心检索功能中接入 AI。此外,像 Perplexity 以及众多国内外专业 AI 搜索工具,也都可供免费使用。从提升搜集资料质量的角度来看,这些工具往往比单纯依赖大模型更具实用性。

不过,用 “猫猫威胁” 大模型的方式,虽不能从根本上解决问题,但却为枯燥的科研工作增添了别样乐趣,也算是从另一个角度提升了科研效率。在这场人类与 AI 的 “斗智斗勇” 中,或许我们可以在合理运用技术的同时,偶尔享受一下这种 “猫鼠游戏” 带来的意外惊喜。你对这种用猫猫整治 AI 乱编文献的方法有何看法呢?它会成为科研人员对抗 AI 幻觉的新 “利器” 吗?